Une percée scientifique révèle pourquoi l’IA générative apprend si bien

Une étude menée par Tony Bonnaire (IAS, CNRS & Université Paris-Saclay) avec Raphaël Urfin et Giulio Biroli (ENS Paris, CNRS & PSL) et Marc Mézard (Université Bocconi) apporte un éclairage inédit sur une question centrale de la recherche en IA générative: la manière dont les modèles de diffusion — technologie clé derrière l’IA générative moderne — parviennent à généraliser efficacement avant de mémoriser les données sur lesquelles ils sont entraînés.

L’essor fulgurant de l’IA a fait émerger une nouvelle génération de modèles capables de produire des images, des sons ou des vidéos d’un réalisme impressionnant. Parmi eux, les modèles de diffusion occupent une place de choix car en apprenant à partir de nombreux exemples, ils parviennent à créer des contenus souvent indiscernables de données réelles. Mais derrière cette prouesse se cache un défi fondamental : comment ces systèmes parviennent-ils à inventer de nouvelles données (images, sons, videos, …), c'est-à-dire généraliser, plutôt qu’à simplement mémoriser puis répéter exactement ce qu’ils ont “appris”?

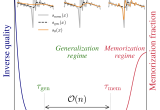

Grâce à une approche interdisciplinaire combinant physique statistique, informatique et expériences numériques, Tony Bonnaire et ses collaborateurs ont fait une découverte essentielle concernant le processus d'apprentissage des modèles de diffusion: l’identification quantitative de deux échelles de temps distinctes et prévisibles une première phase de généralisation indépendante des données d’entrainement, suivie beaucoup plus longtemps après d’une phase de mémorisation dépendant de la taille du jeu de données.

L’équipe montre que le temps de mémorisation recule à mesure que le nombre de données d’entrainement augmente expliquant ainsi que les IA génératives basées sur les modèles de diffusion demeurent dans une phase où elles créent de nouvelle données.

En démontrant que la performance observée des modèles de diffusion et leur succès pratique repose sur un mécanisme démontrable et mesurable qui retarde naturellement le sur-apprentissage, le travail de Tony Bonnaire et ses collaborateurs offre une compréhension profonde et exploitable des mécanismes qui gouvernent l’IA générative moderne. Il établit ainsi un nouveau fondement pour l’analyse scientifique de la généralisation dans l’intelligence artificielle comme le souligne l’attribution du Best Paper Award de NeurIPS 2025. Une reconnaissance exceptionnelle car seuls 4 articles ont été récompensés parmi les 21 575 soumis (dont 5 290 acceptés) à cette conférence la plus prestigieuse du domaine de l’IA.

Article: "Why Diffusion Models Don’t Memorize: The Role of Implicit Dynamical Regularization in Training", Tony Bonnaire, Raphaël Urfin, Giulio Biroli et Marc Mézard

Voir : https://blog.neurips.cc/author/alexlu/

Contact: Tony Bonnaire